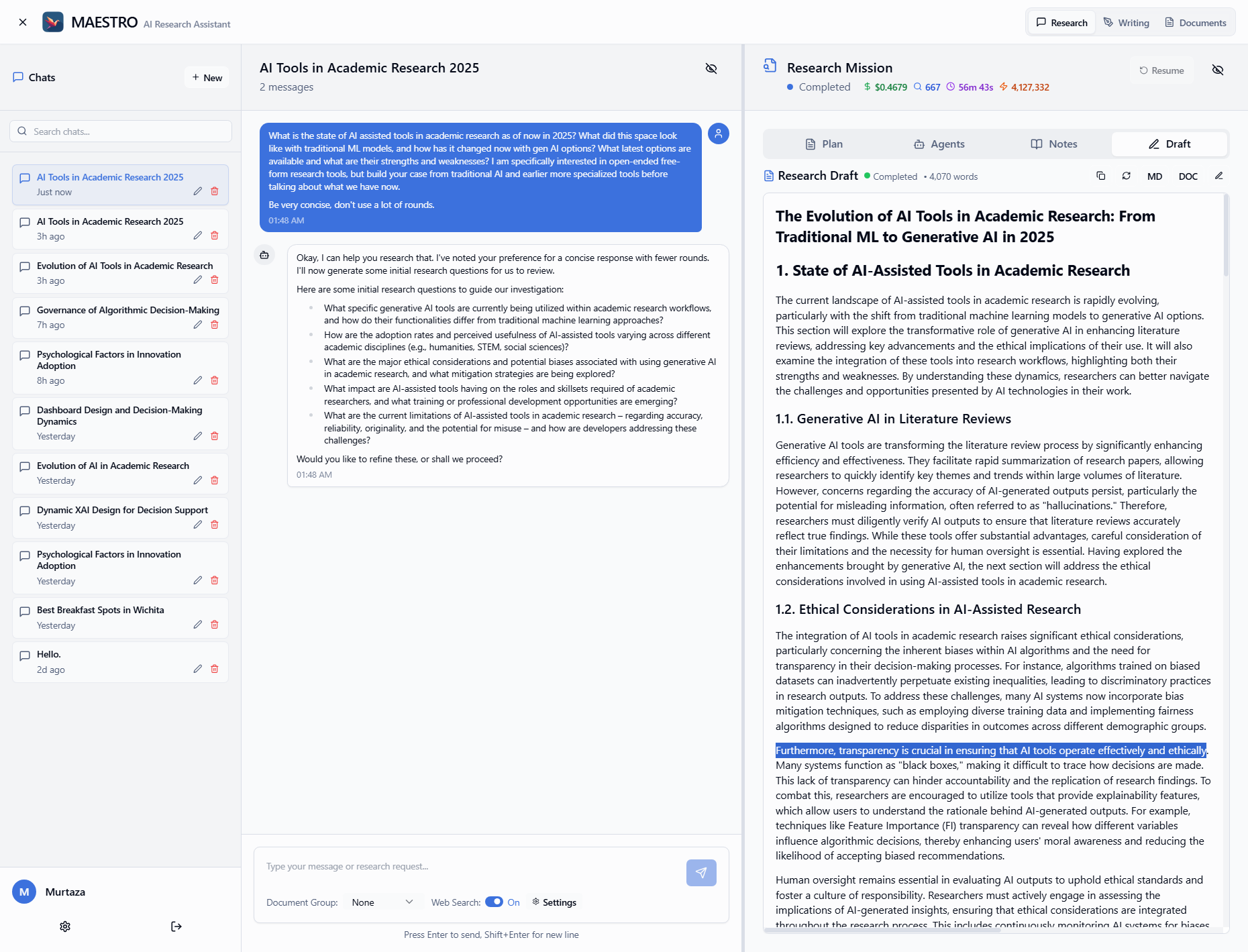

Zola Chat

综合介绍

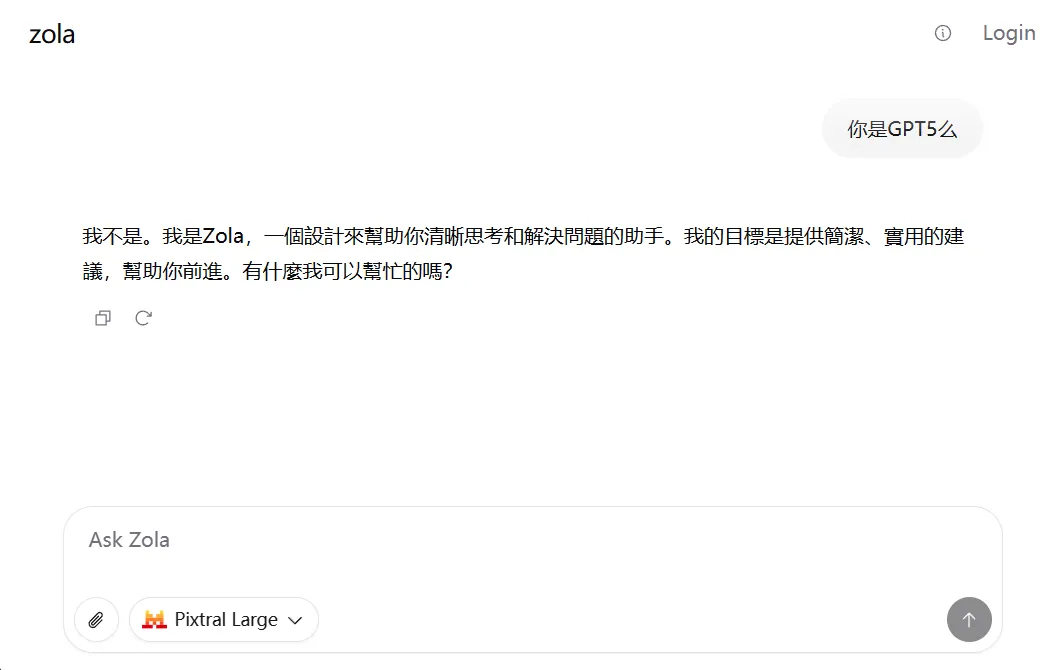

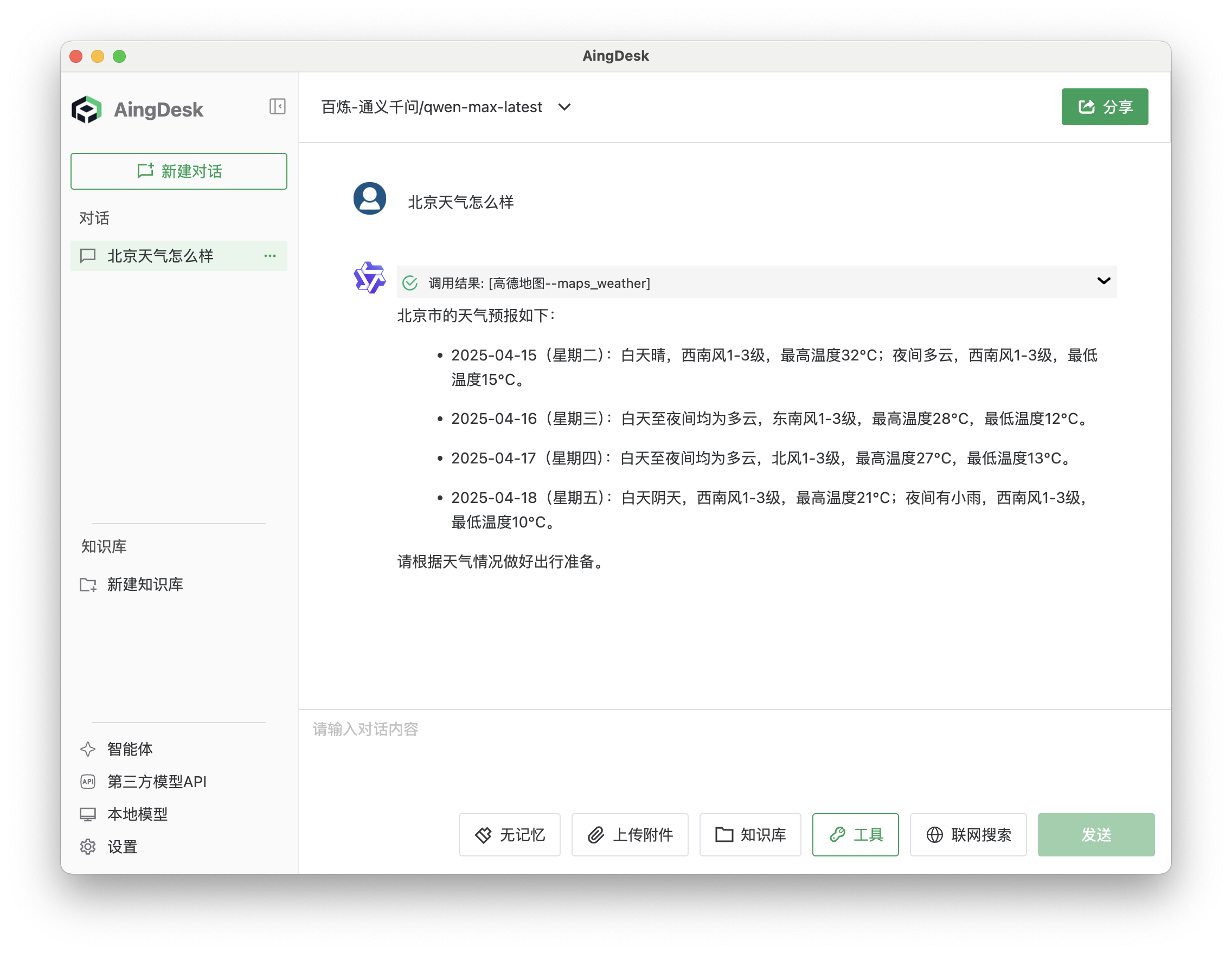

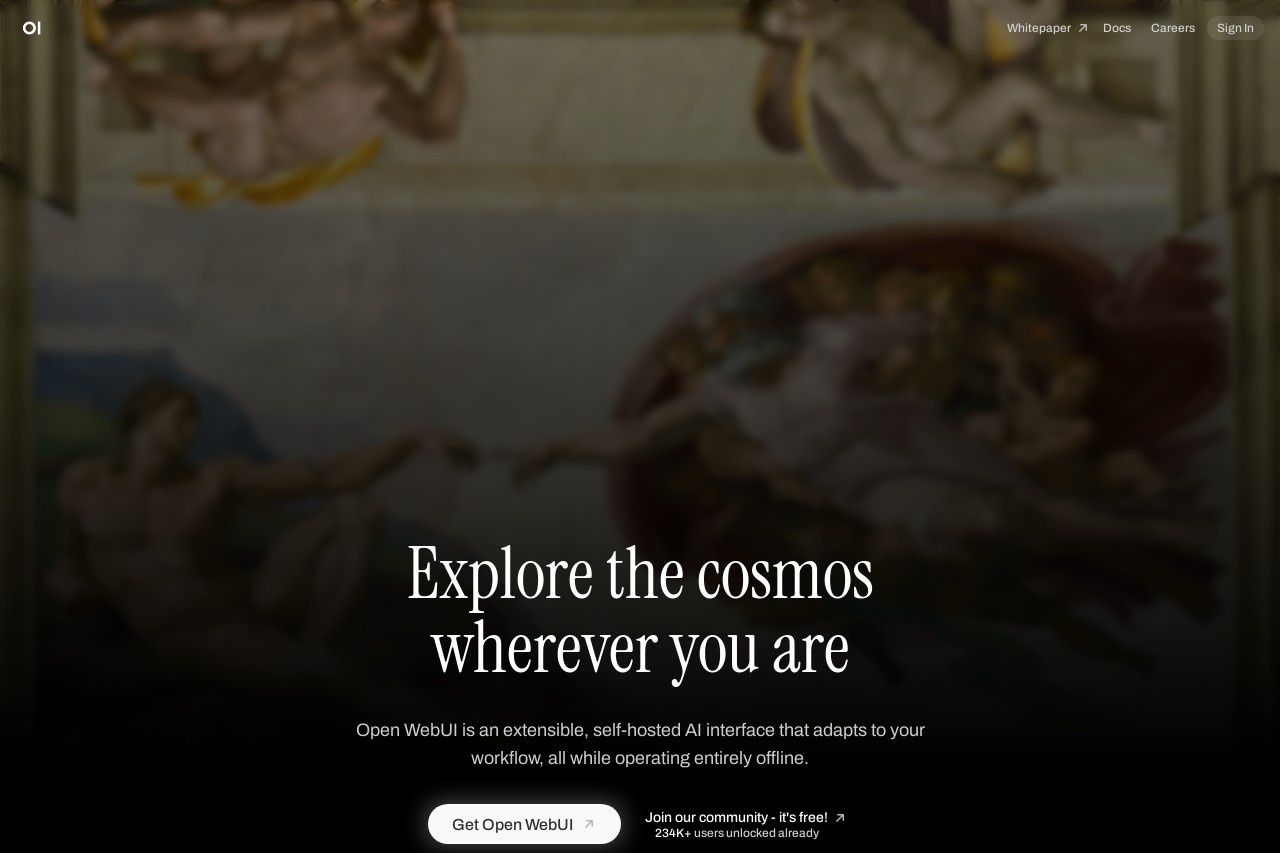

Zola Chat是一款免费、开源的AI聊天应用,它提供了一个简洁的界面,让用户可以与多种主流的人工智能模型进行对话。这个工具最显著的特点是灵活性和开放性。用户无需注册登录,就可以直接访问并开始使用默认的AI模型。如果用户选择通过Google账户登录,每天还可以获得100次调用GPT-4o等更先进模型的免费额度。Zola Chat支持文件上传,能够处理多模态任务。作为一个开源项目,它允许开发者查看源代码、自行修改或部署到自己的服务器上,为那些希望构建定制化AI聊天工具的团队和个人提供了坚实的基础。

功能列表

- 免登录使用: 无需创建账户或登录,即可立即开始与AI对话。

- 支持多种AI模型: 集成了多个主流AI模型,如GPT-4o、Pixtral Large和Mixtral Large,用户可以根据需求切换使用。

- 免费高级模型访问: 通过Google账户登录后,用户每天可以免费发送100条消息来使用GPT-4o等高级模型。

- 文件上传: 支持向聊天中附加文件,可用于数据分析、图像识别等多模态任务。

- 开源且可自托管: 项目代码完全开源,开发者可以自由地进行修改、二次开发,或将其部署在自己的服务器上。

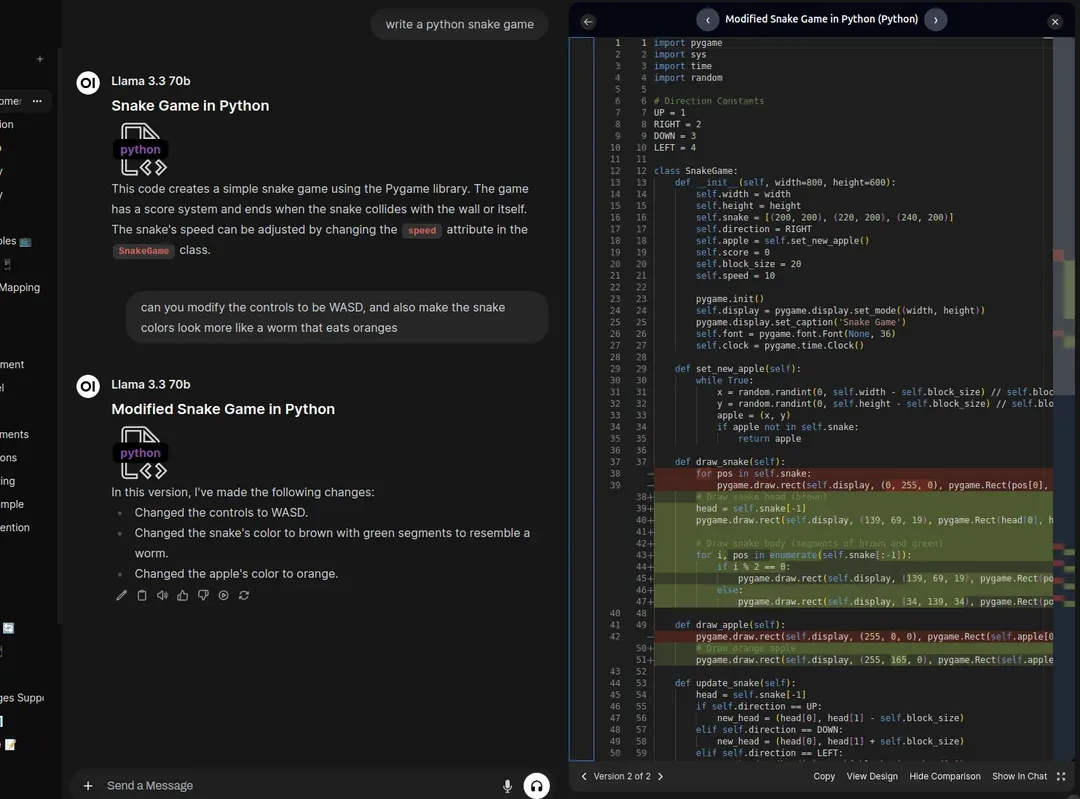

- 本地模型支持: 支持通过Ollama运行本地AI模型,实现了在没有互联网连接的情况下与AI交互,并确保了数据隐私。

- 简洁的用户界面: 界面设计干净直观,支持亮色和暗色模式,并且在移动设备上也有良好的显示效果。

- 对话提示建议: 提供了一些起始对话建议,帮助用户快速开始或获得灵感。

使用帮助

Zola Chat的设计目标是让用户开箱即用,无论是在官方网站直接使用,还是在自己的服务器上进行部署,流程都非常简单。

一、 在线使用

对于普通用户来说,最快捷的方式是直接使用官方网站提供的服务。

- 访问网站: 在浏览器中打开网址

https://www.zola.chat/。 - 立即开始对话:

- 页面加载后,你会看到一个对话框,可以直接在输入框“What's on your mind?”中输入你的问题或指令。

- 默认情况下,你将以匿名用户的身份使用Pixtral Large模型进行对话。

- 使用高级功能 (可选):

- 如果你希望使用像GPT-4o这样的高级模型或上传文件,可以点击页面右上角的“Login”按钮。

- 目前支持使用Google账户进行登录。登录后,你将获得每天100条消息的免费额度来使用高级模型。

- 登录后,界面上通常会出现模型选择的下拉菜单,你可以在此切换不同的AI模型。

- 上传文件:

- 在登录状态下,对话输入框旁边会出现一个附件或文件的图标。

- 点击该图标,从你的设备中选择需要分析的文件(如文档、图片等),即可将其上传并让AI进行处理。

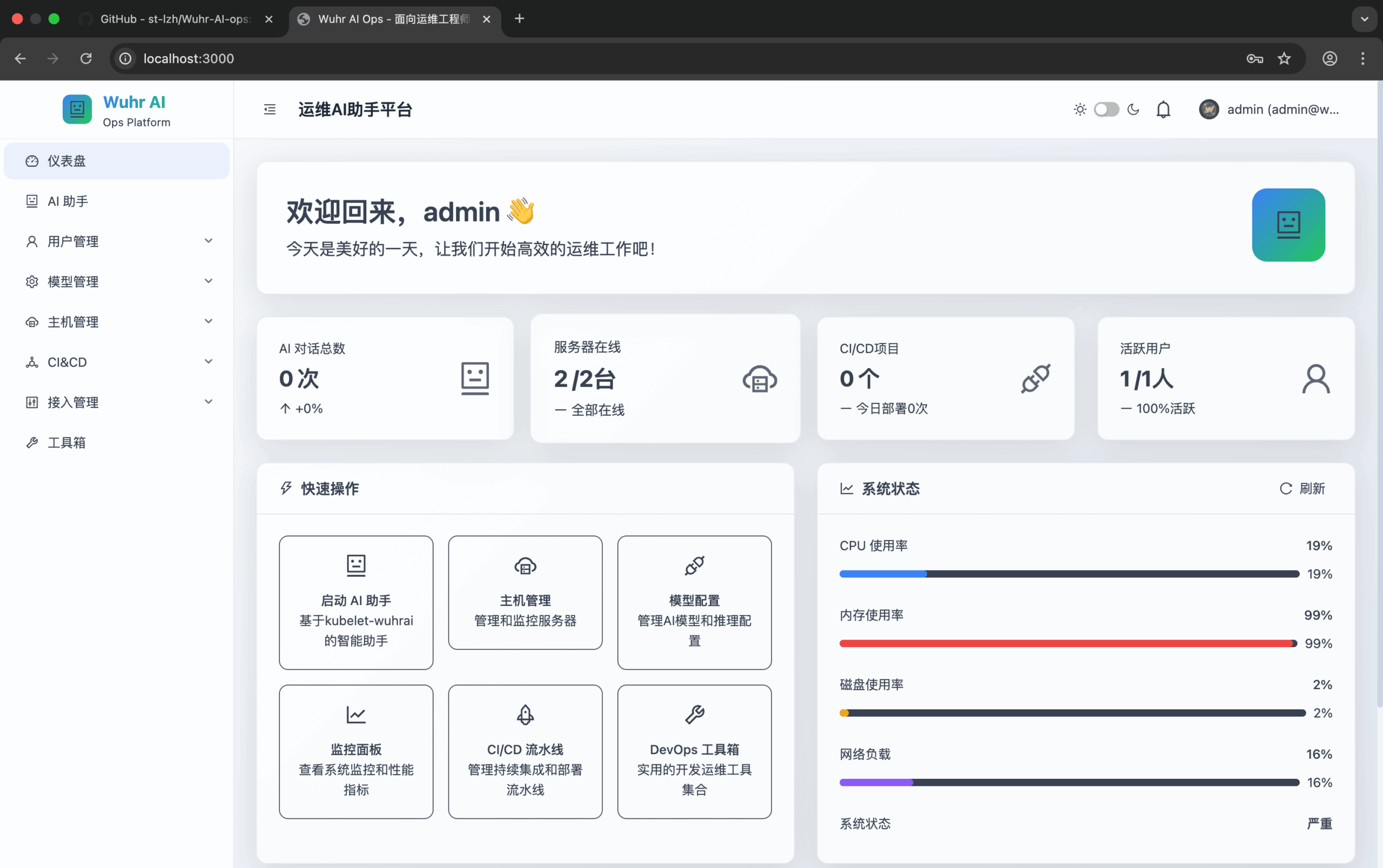

二、 本地部署和自托管

对于开发者或希望完全掌控数据的用户,Zola Chat提供了非常方便的自托管选项。这允许你在自己的电脑或服务器上运行整个应用。

准备工作

在开始之前,请确保你的电脑上已经安装了Git和npm (Node.js包管理器)。

选项1: 使用OpenAI模型进行部署

如果你拥有OpenAI的API密钥,可以按照以下步骤部署:

- 克隆代码库: 打开终端或命令行工具,输入以下命令将项目代码下载到本地。

git clone https://github.com/ibelick/zola.git - 进入项目目录:

cd zola - 安装依赖:

npm install - 配置API密钥: 创建一个名为

.env.local的文件,并在其中写入你的OpenAI API密钥。echo "OPENAI_API_KEY=your-key" > .env.local请将

your-key替换成你自己的密钥。 - 启动应用:

npm run dev应用成功启动后,在浏览器中访问

http://localhost:3000即可看到你自己的Zola Chat实例。

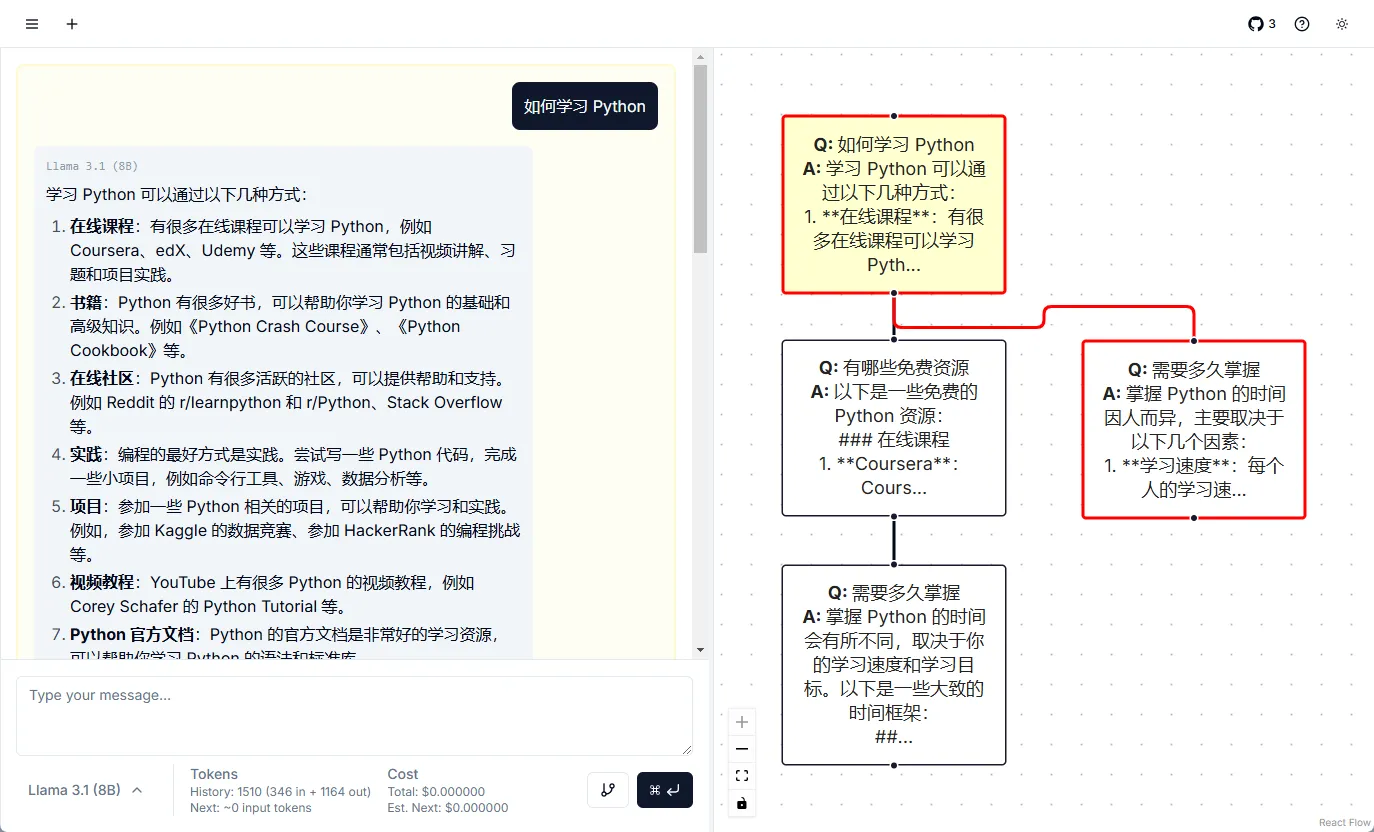

选项2: 使用Ollama运行本地模型

如果你希望在本地运行AI模型,从而实现离线使用和数据隐私保护,可以使用Ollama。

- 安装并运行Ollama:

- 在终端中执行以下命令来安装并启动Ollama服务。

curl -fsSL https://ollama.ai/install.sh | sh- 下载一个你偏好的模型,例如Llama 3.2。

ollama pull llama3.2 - 克隆并运行Zola:

- 按照选项1中的步骤克隆代码库并安装依赖。

git clone https://github.com/ibelick/zola.git cd zola npm install- 直接启动Zola应用。

npm run dev- Zola会自动检测到你本地正在运行的Ollama模型,并在模型列表中显示它们,供你选择使用。

选项3: 使用Docker进行部署

如果你熟悉Docker,可以使用docker-compose来快速启动一个包含Ollama的完整环境。

- 克隆代码库:

git clone https://github.com/ibelick/zola.git - 进入目录:

cd zola - 使用Docker Compose启动:

docker-compose -f docker-compose.ollama.yml up这个命令会自动构建并启动Zola和Ollama两个服务,实现快速部署。

应用场景

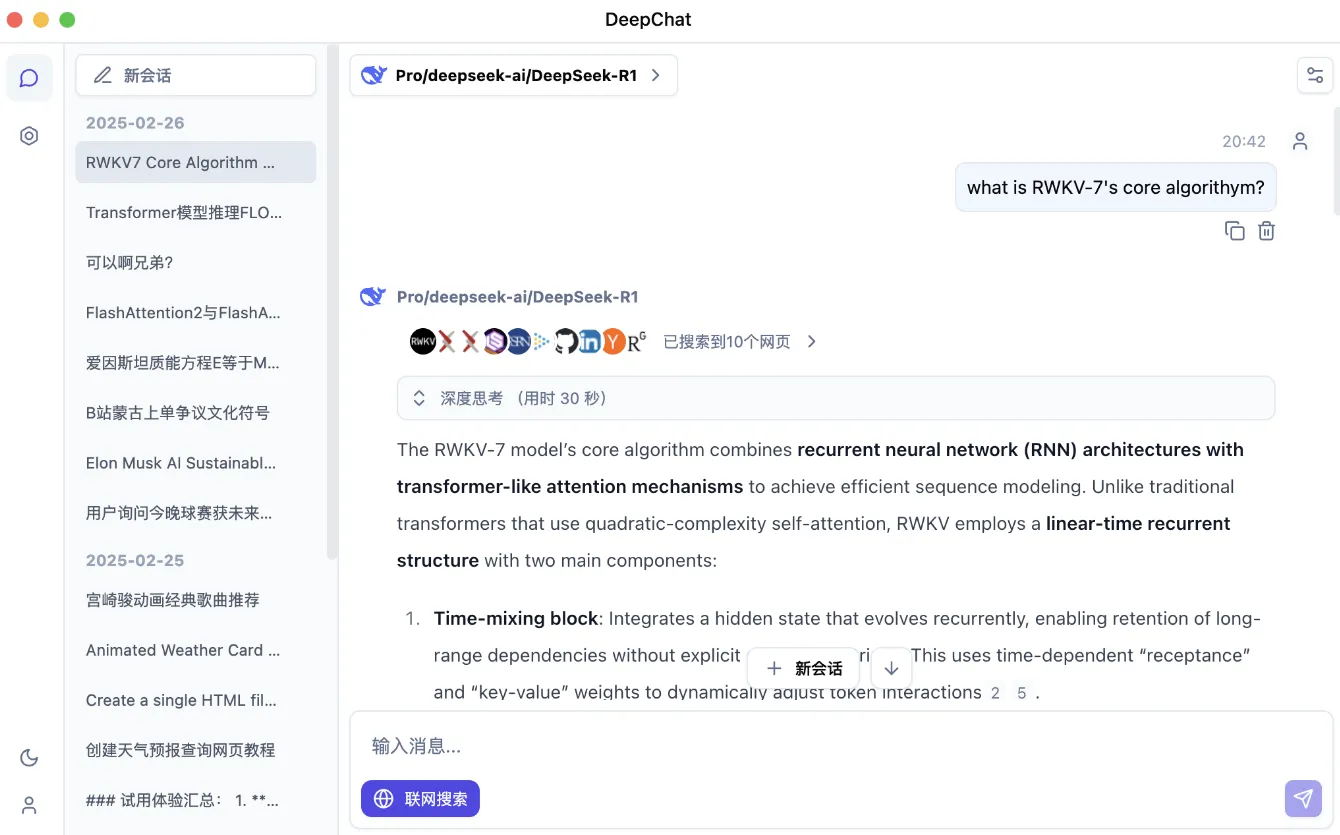

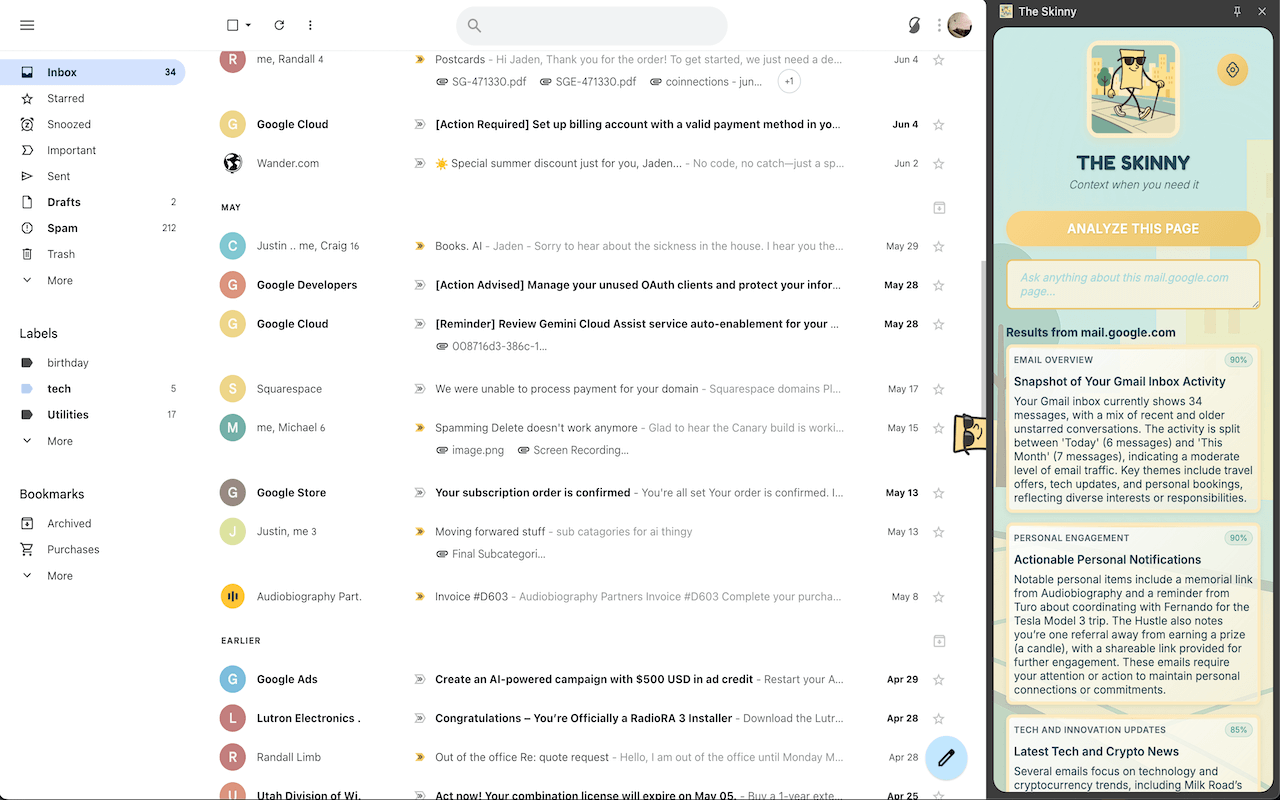

- 快速问答和创意生成当需要快速查找资料、获取代码片段或激发创意时,可以直接打开Zola Chat网站,无需登录即可向AI提问,获得即时回答。这比登录其他需要账户的AI平台更加高效。

- 免费体验高级AI模型对于想尝试GPT-4o等顶级AI模型但又不想付费订阅的用户,可以通过Google账户登录Zola Chat。每天100条的免费额度足以应对处理复杂任务、论文润色或深度分析等非高频次的使用需求。

- 构建企业或团队内部AI工具由于Zola Chat是开源的,开发者可以将其作为基础模板。在此之上进行二次开发,例如接入公司内部知识库、添加特定的业务逻辑,从而为团队打造一个安全、可控且定制化的内部AI助手。

- 学习和研究AI应用开发开发者可以通过研究Zola Chat的源代码,学习如何使用Vercel AI SDK、Supabase等现代技术栈来构建一个完整的AI聊天应用。这包括如何集成多种模型、处理流式响应以及如何通过身份验证管理用户。

QA

- Zola Chat是完全免费的吗?是的,Zola Chat是一个免费使用的工具。你可以不登录直接使用,也可以通过Google账户登录,免费使用更高级的模型(每日有100条消息限制)。作为一个开源项目,你也可以免费在自己的服务器上部署它。

- Zola Chat支持哪些AI模型?Zola Chat支持多种模型,包括OpenAI的GPT系列(如GPT-4o)、Mistral的模型以及通过Ollama运行的本地模型(如Llama 3.2)。

- 使用Zola Chat需要注册账号吗?不需要。你可以直接匿名使用其基础功能。只有当你需要使用GPT-4o等高级模型或上传文件时,才需要通过Google账户进行免费登录。

- 我可以在自己的服务器上部署Zola Chat吗?可以。Zola Chat是开源的,官方提供了详细的自托管安装说明,包括使用OpenAI API、Ollama本地模型或Docker的多种部署方式。

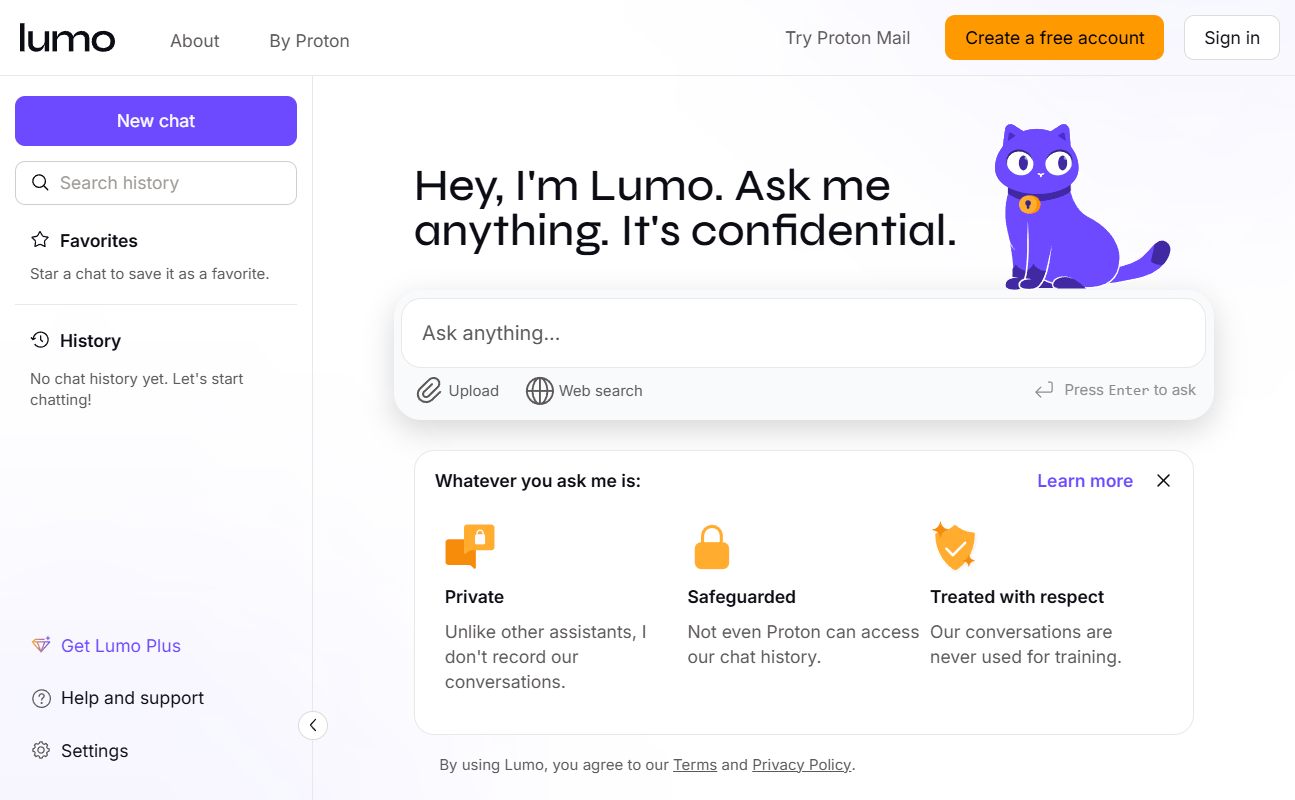

- 上传文件功能安全吗?对于在线版本,文件上传的安全性由其后端服务(Supabase)提供保障。如果你对数据隐私有极高要求,建议采用自托管的方式,在本地通过Ollama运行模型,这样你的所有数据都将保留在自己的设备上,不会发送到任何外部服务器。